دیپ فیک چيست؟

خود اوباماست، نگاهمان میکند و میگوید ترامپ احمق است. اما اوباما نیست یک دیپ فیک است؛ یک ویدیوی دستکاری شده. برخی نگران گسترش چنین ویدیوهایی هستند. خطر دیپ فیک چیست و قربانیان آن چه کسانی هستند؟

به گزارش گروه وب گردی

خبرگزاری صدا و سیما؛ روزگاری بود که میگفتند: تا با چشم خودت ندیدهای یا با گوش خودت نشنیدهای، باور نکن. اما آیا این گفته در مورد انسان امروزی در یکی از نقشهایش به عنوان کاربر اینترنت و بیننده و شنونده محتوایی که روزانه در شبکهها منتشر میشود هم درست است؟ برای نمونه وقتی که چشم میبیند که باراک اوباما، رئیس جمهور آمریکا در تصویر، مقابل دوربین به بیننده زل زده و گوش میشنود که همین رئیس جمهور پیشین، دونالد ترامپ را یک احمق مینامد.

به عصر "دیپ فیک" ها خوش آمدید. روزگاری که در آن نه باید به گوش اعتماد کرد و نه به چشم، یا دستکم به گوش و چشم آموخت که اصل را از جعل تشخیص دهند. ویدیوی باراک اوباما که در مثال آمد، تنها نمونهای از محتوایی است که به آن "دیپفیک" (یا جعل عمیق) میگویند.

دیپ فیک چیست؟

دیپفیک به ویدیوهای دستکاری شده میگویند؛ ویدیوهایی که در آنها میتوان سر شخصی را که در فیلم دیده میشود با دیگری عوض کرد، حرفهایی توی دهانش گذاشت که تا به حال نزده و حالاتی به بدن او داد که تا به حال از او دیده نشده است.

دیپ فیکها یکی از از دستاوردهای هوش مصنوعی هستند که میتوانند برای نمونه حرکات و چهره یک نفر را دستکاری کنند و حرفهای ناگفته توی دهانش بگذارند. این ویدیوهای جعلی که با بهرهگیری از Deep Learning (یادگیری ژرف) و حجم عظیمی از دادهها و شبکه عصبی مصنوعی ساخته میشوند، نتیجه محاسبات پیچیدهای هستند که برای نمونه میتوانند از دو ویدیو (دو منبع تصویری)، یک ویدیوی جعلی تازه خلق کنند. البته همانگونه که اشاره شد، این دستکاری تنها به ویدیو خلاصه نمیشود؛ با این تکنولوژی میتوان صداها را هم دستکاری کرد به گونهای که شخصی جملهای را بر زبان بیاورد که هیچگاه نگفته است.

دیپ فیک چگونه متولد شد؟

سال ۲۰۱۴ یان گودفلو، یکی از پژوهشگران نامدار عرصه یادگیری ژرف و هوش مصنوعی در آمریکا، سیستم شبکههای رقابتی مولد را که به اختصار GAN نام دارند، به دنیای تکنولوژی معرفی کرد؛ GANها از جمله میتوانستند به عنوان ابزاری مفید در سیستمهای هوش مصنوعی برای تولید عکسها و ویدیوهایی که حالا آنها را دیپ فیک مینامیم، به کار روند.

سه سال گذشت تا این کشف جدید را صنعت پورنوگرافی به خدمت بگیرد. در پلتفرم "ردیت" یک کاربر ویدیویی پست کرد که در آن چهره افراد مشهور روی بدن بازیگران فیلمهای پورنو گذاشته بود. این کاربر نام ویدیویش را "دیپ فیک" گذاشت. ویدیو توجه ها را به خودش جلب کرد و ژانر تازهای در دنیای "فیک" ها خلق شد: دیپ فیک.

پورنوگرافی، علاقمند به دیپ فیک

هر چند این ویدیو به سرعت از این صفحه پاک شد اما جذابیت این ابتکار برای بسیاری از کاربران عادی فراموشنشدنی بود. برای ساخت چنین ویدیوهایی نه نیاز به مهارت خاصی بود و نه ابزار بسیار ویژهای. کاربرانی با امکانات بسیار سادهای مانند Fake App شروع به ساخت ویدیوهای اینچنینی برای سرگرمی کردند.

در بسیاری از حوزهها میشد از دیپ فیک بهره جست. صنعت فیلمسازی و بازیهای کامپیوتری و حتی صنعت مد، حوزههایی بودند که بیش از پیش به این نوآوری علاقه نشان دادند. اما استفاده از این فناوری مانند هر نوآوری دیگری، بیخطر نماند: سوژهای که در بیشتر این ویدیوها به چشم میخورد، استفاده از چهره زنان مشهور بود بر بدنی دیگر، در متنی سکسیستی. طبق گزارشهای منتشر شده، بیش از ۹۰ درصد از محتوای تولید شدهای که نام دیپ فیک بر آن مینهند و در شبکه در حال چرخش است، محتوای پورن است.

خدمت و خیانت دیپفیکها به سیاست و سیاستمداران

اما این تنها زمینه سوءاستفاده از دیپفیکها نیست. آنچه این روزها به بحثها و نگرانیهای زیادی در مورد دیپفیکها دامن زده است، پتانسیل سوءاستفاده از آن برای مثال در حوزههای سیاسی و امنیتی است. مشکل اساسی به نظر بسیاری از کارشناسان از آنجایی شروع میشود که حرفهای جنجالی در دهان سیاستمداران گذاشته شود. از دیگر سوءاستفادههایی که میتوان برای این تکنولوژی تصور کرد، بهرهگیری ازاین "جعل" برای زهرچشم گرفتن و خاموش کردن فعالان سیاسی و مدنی یا خبرنگاران است.

کم نیستند کارشناسانی که میگویند در روزگاری که سیاستمداران میتوانند به راحتی دروغ بگویند، نیازی به دیپ فیک برای تخریب رقیب سیاسی آنها نیست

در این میان یکی از موضوعهایی که به ویژه به نگرانی سیاستمداران دامن زده، نزدیکشدن به انتخابات آمریکا و سوءاستفاده از دیپ فیک در فضای پیشاانتخاباتی این کشور است. سال ۲۰۱۶ آنچه که بر انتخابات ریاست جمهوری آمریکا سایه افکند، موضوع انتشار اطلاعات اشتباه، فیک نیوز، بود و ظن تلاش برای دستکاری اطلاعات. اکنون پیش از انتخابات ۲۰۲۰ آمریکا و در فضایی که هر جرقهای میتواند آتش دودستگی را در این کشور شعلهور کند، بیم و نگرانی از دیپ فیکها و نقش احتمالی آنها در انحراف افکار عمومی برجسته میشود.

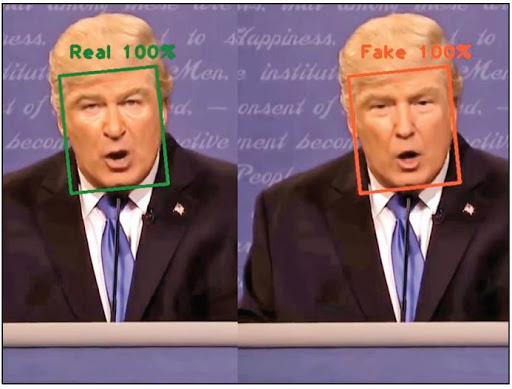

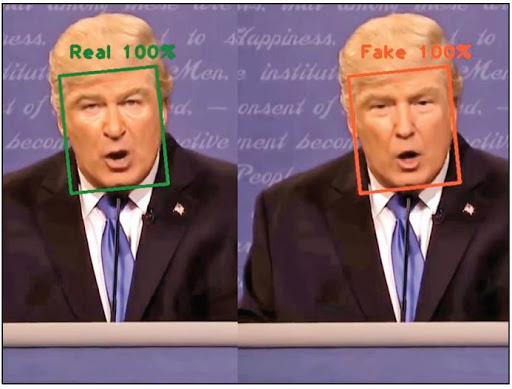

تلاش برای مقابله با دیپفیکها از راه تشخیص اصل از جعل

نگرانی سیاستمداران جدی است، تا آنجا که دست به کار شدهاند. آژانس پروژههای پیشرفته دفاعی وزارت دفاع آمریکا (Darpa) میلیونها دلار بودجه برای پژوهش در مورد راههای تشخیص دیپ فیک اختصاص داده است. این مرکز تحقیقاتی تنها نیست؛ فیس بوک و گوگل هم برای رسیدن به متدهایی که چنین محتوایی را از اصل تشخیص و تمییز دهد، هزینه میکنند.

آژانسهای خبری مانند رویترز از همین حالا برای مبارزه و تشخیص دیپفیکها خودشان را مجهز میکنند. رویترز با تنظیم "فکتنچکر" سعی میکند خود را مجهز کند. اما مسئول بخش یوجی سی و راستآزمایی یوجی سی رویترز میگوید، دیپ فیکهای بسیار خوب حتی حرفهای ها را هم به اشتباه میاندازند.

هائو لی، پروفسور دانشگاه کالیفرنیای جنوبی که یکی از زمینههای فعالیتش هوش مصنوعی است، در مصاحبهای با روزنامه آلمانی دیتسایت میگوید، احتمال اینکه به زودی با پیشرفت فناوری دیپفیکهایی تولید شوند که نه انسان و نه ماشین قادر به تشخیص اصل یا جعل بودن آنها نباشند، زیاد است. یعنی به گفته این پژوهشگر، در آیندهای نه چندان دور، نه چشم ما و نه متخصصان قادر به تشخیص دستکاری نخواهند بود. این متخصص برای اثبات پیشبینی خود به سرعت رشد این تکنولوژی اشاره میکند و پیشرفتی کیفی که در فاصله زمانی کوتاهی در این ویدیوها دیده میشود.

وقتی که به "اصل" هم دیگر اعتماد نمیکنیم

اما خطر دیپ فیکها تنها این نیست که نتوانیم ویدیو و محتوای جعلی را تشخیص دهیم. نگرانی وقتی بزرگتر میشود که "اصل" را ببینیم و بشنویم ولی گمان بر "جعل" بودن آن ببریم. اتفاقی که در کمتر از یک سال پیش افتاد.

در دسامبر سال ۲۰۱۸ در کشور گابُن در فیس بوک ویدیویی پست شد که در آن، رئیس جمهور این کشور، علی بونگو سخنرانی میکرد. ماهها بود که بونگو در تلویزیون و مراسم دیگر ظاهر نشده بود و بسیاری مردم احتمال بیماری شدید یا حتی احتمال مرگ او را میدادند. با انتشار این ویدیو، رقیبان سیاسی، آن را دیپ فیک نامیدند و همین موضوع یکی از علتهای کودتای ارتش در چند هفته بعد از انتشار ویدیو شد.

این تنها نمونهای است از آنچه دیپفیک میتواند در دنیای سیاست به بار بیاورد؛ یک احتمال و دست به کار شدن، بدون راستیآزمایی احتمال و محتوا.

قربانی زناناند و شهروندان عادی

با این وجود هستند متخصصان و کارشناسانی که میگویند، شاید "دیپ فیک" پدیدهای نو باشد، اما "جعل" پدیدهی امروز نیست؛ دستکاری کردن سطحی تا پیچیده عکس با فوتوشاپ تا نشاندن متنی که با عکس مرتبط نبوده، در پای تصویر ... مثالها زیاد است از آنچه کارشناسان آن را "چیپ فیک:دستکاری سطحی" مینامند و معتقدند، تا بوده همین بوده.

این کارشناسان خطر دیپ فیک را نه آنگونه که تبلیغ میشود، متوجه سیاستمداران، خبرنگاران، و در کل آدمهای مشهور میدانند که معتقدند، کاربران عادی و به ویژه زنان قربانی اصلی دیپ فیکها هستند و باید برای مقابله با آن به فکر چاره بود؛ زنانی که قربانی انتقام میشوند و سرشان روی بدن یک پورناستار قرار میگیرد و فیلمشان منتشر میشود یا دانشآموزانی که با این روش موبینگ میشوند یا شهروندان عادی که از این طریق از آنها اخاذی میشود.

کم نیستند کارشناسانی که در مورد نگرانی بزرگی که در مورد سوءاستفاده سیاسی از دیپ فیک وجود دارد، بر این باورند که، برای پروپاگاندا و تخریب، روشهای دیگر آسانتر و باورپذیرترند تا تعویض برای نمونه سر ترامپ با سارکوزی.

هرچند خطر دیپ فیک را نباید دست کم گرفت اما برای نمونه برای تخریب رقیب سیاسی در یک کارزار انتخاباتی، حتما نباید دست به دامن دیپ فیک شد، میتوان به دوربین زل زد و در برابر میلیونها بیننده، دروغ گفت.